この記事はTensorFlowのドキュメント「はじめてのニューラルネットワーク:分類問題の初歩」を参考に作成した記事になります。

ライブラリのインポート

# TensorFlow と tf.keras のインポート

import tensorflow as tf

from tensorflow import keras

# ヘルパーライブラリのインポート

import numpy as np

import matplotlib.pyplot as plt

print(tf.__version__)MNISTデータセットのロード

mnist = keras.datasets.mnist

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()- train_images:訓練用データ

- train_labels:訓練用データの正解ラベル

- test_images:テスト用データ

- test_labels:テスト用データの正解ラベル

データの観察

train_images.shape

(60000, 28, 28)28*28 ピクセルの画像60,000枚を train_images に格納しています。

今回のニューラルネットワークは60,000枚の画像データの特徴を学習します。

train_images の中身を見てみると 最小値は0、最大値は255でした。

print(train_images[0])

array([[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 3,

18, 18, 18, 126, 136, 175, 26, 166, 255, 247, 127, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 30, 36, 94, 154, 170,

253, 253, 253, 253, 253, 225, 172, 253, 242, 195, 64, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 49, 238, 253, 253, 253, 253,

253, 253, 253, 253, 251, 93, 82, 82, 56, 39, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 18, 219, 253, 253, 253, 253,

253, 198, 182, 247, 241, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 80, 156, 107, 253, 253,

205, 11, 0, 43, 154, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 14, 1, 154, 253,

90, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 139, 253,

190, 2, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 11, 190,

253, 70, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 35,

241, 225, 160, 108, 1, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

81, 240, 253, 253, 119, 25, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 45, 186, 253, 253, 150, 27, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 16, 93, 252, 253, 187, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 249, 253, 249, 64, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 46, 130, 183, 253, 253, 207, 2, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 39,

148, 229, 253, 253, 253, 250, 182, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 24, 114, 221,

253, 253, 253, 253, 201, 78, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 23, 66, 213, 253, 253,

253, 253, 198, 81, 2, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 18, 171, 219, 253, 253, 253, 253,

195, 80, 9, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 55, 172, 226, 253, 253, 253, 253, 244, 133,

11, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 136, 253, 253, 253, 212, 135, 132, 16, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0],

[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0,

0, 0]], dtype=uint8)データの前処理

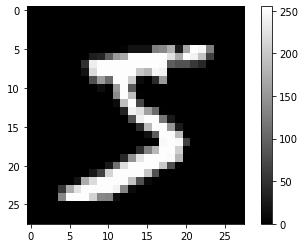

plt.figure()

plt.imshow(train_images[0], cmap='gray')

plt.colorbar()

plt.grid(False)

plt.show()

画像の右側の値は画像を表現している数値を表しています。

ニューラルネットワークにデータを投入する前にはよくこれらの値を0から1までの範囲にスケールします。

最大値である255で割ります。

train_images = train_images / 255.0

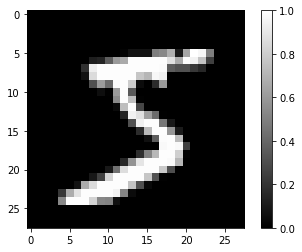

test_images = test_images / 255.0改めて画像を表示してみると0から1の範囲にスケールされていることがわかります。

plt.figure()

plt.imshow(train_images[0], cmap='gray')

plt.colorbar()

plt.grid(False)

plt.show()画像を出力してみました。

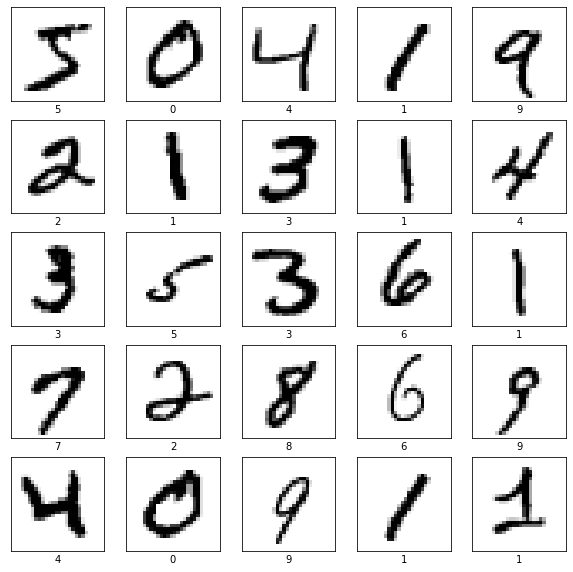

訓練データの最初の25枚を表示してみました。

plt.figure(figsize=(10,10))

for i in range(25):

plt.subplot(5,5,i+1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(train_images[i], cmap=plt.cm.binary)

plt.xlabel(train_labels[i])

plt.show()

モデルの構築

層の設定

model = keras.Sequential([

keras.layers.Flatten(input_shape=(28, 28)),

keras.layers.Dense(128, activation='relu'),

keras.layers.Dense(10, activation='softmax')

])モデルの確認

model.summary()

Model: "sequential"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

flatten (Flatten) (None, 784) 0

_________________________________________________________________

dense (Dense) (None, 128) 100480

_________________________________________________________________

dense_1 (Dense) (None, 10) 1290

=================================================================

Total params: 101,770

Trainable params: 101,770

Non-trainable params: 0

_________________________________________________________________モデルのコンパイル

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])モデルの訓練

model.fit(train_images, train_labels, epochs=10)

Epoch 1/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.4333 - accuracy: 0.8807

Epoch 2/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.1236 - accuracy: 0.9639

Epoch 3/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.0809 - accuracy: 0.9760

Epoch 4/10

1875/1875 [==============================] - 3s 2ms/step - loss: 0.0573 - accuracy: 0.9826

Epoch 5/10

1875/1875 [==============================] - 3s 2ms/step - loss: 0.0431 - accuracy: 0.9870

Epoch 6/10

1875/1875 [==============================] - 3s 2ms/step - loss: 0.0336 - accuracy: 0.9895

Epoch 7/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.0274 - accuracy: 0.9921

Epoch 8/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.0214 - accuracy: 0.9935

Epoch 9/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.0185 - accuracy: 0.9938

Epoch 10/10

1875/1875 [==============================] - 3s 1ms/step - loss: 0.0142 - accuracy: 0.9959正解率の評価

test_loss, test_acc = model.evaluate(test_images, test_labels, verbose=2)

print('\nTest accuracy:', test_acc)

313/313 - 0s - loss: 0.0962 - accuracy: 0.9777

Test accuracy: 0.9776999950408936テストデータの正解率は97%という結果を得ることができました。

予測する

predictions = model.predict(test_images)

predictions[0]

array([7.2235855e-07, 2.5614092e-13, 4.2602270e-08, 1.5744107e-06,

2.9314206e-13, 8.8045432e-10, 3.8204596e-12, 9.9999714e-01,

4.8923154e-09, 5.8253812e-07], dtype=float32)predict関数に test_images を入れて、一つ目の出力を確認してみました。

数字が多く少しわかりずらいので、Numpy の argmax を使って最大値のインデックス番号を出力してみます。

np.argmax(predictions[0])

7「7」が出力されました。

test_labels[0]

7テストデータの正解ラベルを確認してみると「7」が出力され、モデルは正しく予測ができた。

ということになります。